Ceci est une ancienne révision du document !

La nouveauté, le portail Cloud@CBP

Pour simplifier l'accès aux ressources du Centre Blaise Pascal, le portail Cloud@CBP permet de visualiser et sélectionner les ressources disponibles.

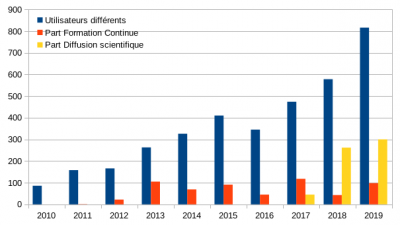

Une utilisation toujours croissante

Un ensemble de plateaux techniques

A l'origine, les ressources informatiques du Centre Blaise Pascal étaient celles du Cecam, essentiellement cantonnées à la salle informatique.

Maintenant, le Centre Blaise Pascal dispose d'un ensemble de plateaux techniques destinés à la formation, l'étude (de l'expérience au prototypage), le développement ou la qualification dans tous les segments de l'informatique scientifique :

- plateau multi-noeuds : 116 noeuds de cluster v20z, x2200, x41z, x4500, r410, sl230 et c6100 totalisant presque 1000 coeurs

- plateau multi-coeurs : 116 noeuds de cluster, 60 stations de travail de 2 à 64 coeurs

- plateau GPU : 4 noeuds de cluster de prêt et 60 stations de travail. avec 70 GPU différents

- plateau Atelier en Humanités Numériques

- plateau “intégration logicielle” : distributions Debian, Ubuntu, CentOS

- plateau “intégration matérielle” : Sparc 32, PowerPC, ARM (sur demande)

- plateau “Visualisation 3D” : 2 stations, 4 paires de lunettes, 2 vidéoprojecteurs

- plateau COMOD : “Compute On My Own Device”

- plateau Galaxy

- plateau pour les ateliers 3IP pour "Introduction Inductive à l'Informatique et au Parallélisme"

Pour simplifier l'accès à la majorité de ces machines, le portail Cloud@CBP existe : il permet

- de visualiser les ressources disponible

- de sélectionner un type de machine en fonction de ses ressources

Ces plateaux reposent essentiellement sur :

- une infrastructure logicielle cohérente

- des équipements matériels génériques

- une salle de formation correctement équipée

- des clusters hétérogènes de récupération

- un environnement d'administration simplifié SIDUS

L'utilisation des clusters (plateaux multi-noeuds & multi-coeurs) se base sur GridEngine.

Infrastructure logicielle cohérente

La totalité des serveurs, des stations de travail et des postes de travail fonctionnent sous le système d'exploitation GNU/Linux, intégré au sein de la distribution Debian.

Tous les postes à destination des utilisateurs sont équipés en standard d'un certain nombre de paquets exploités dans les générations précédentes de systèmes. L'installation de sous les paquets science n'est plus systématique sur la version Stretch actuellement en service.

L'intérêt de disposer de la même distribution, dans la même version, permet de faciliter au maximum la portabilité d'un équipement à l'autre, et donc limiter les temps d'intégration : un outil développé sur un poste de travail pourra être compilé voire exécuté sans difficulté sur un autre équipement.

Un certain nombre d'applications scientifiques complémentaires (OpenSource ou propriétaires) ont été installées :

SageMath en GPL et son installation,

BigDFT en GPL et son installation,

CPMD en CPMD free-licence et son installation,

Lammps en GPL et son installation,

VMD et son installation,

Molden et son installation,

Gaussian propriétaire et son installation,

Amber9 propriétaire et son installation,

…

Équipements informatiques matériels

Équipements généraux

- 30 serveurs physiques :

- 22 serveurs de KVM ou de fichiers

- 8 serveurs de fichiers

Salle informatique de 28 postes

La salle informatique M7-1H04 de travaux pratiques comprend :

- 12 stations de travail Precision T5600 avec E5-2620 et 32/64 Go

- gtx690 : Nvidia GTX 690 avec 2x2Go

- gtx680 : Nvidia GTX 680 avec 2Go, Nvidia GT1030 avec 2Go

- gtx980 : Nvidia GTX 980 avec 4Go, Nvidia GT1030 avec 2Go

- gtxtitan : Nvidia GTX Titan avec 6Go, Nvidia K420 avec 2Go

- gtx780ti : Nvidia GTX 780Ti avec 3Go, Nvidia K2000 avec 2Go

- q4000alpha : Nvidia K4000 avec 3Go et capacité 3D

- gtx960 : Nvidia GTX 960 avec 2Go, Nvidia GT710 avec 2Go

- gtx970 : Nvidia GTX 970 avec 2Go, Nvidia GT1030 avec 2Go

- gtx980tialpha : Nvidia GTX 980Ti avec 6Go, Nvidia GTX 750Ti avec 2Go

- gtx980tibeta : Nvidia GTX 980Ti avec 6Go, Nvidia P600 avec 2Go

- gtx980tidelta : Nvidia GTX 980Ti avec 6Go, Nvidia K420 avec 1Go

- gt730 : Nvidia GT 730 avec 2Go, Nvidia RTX 2080 avec 8Go

- 4 stations de travail Precision T5610 avec 2 E5-2609v2 et 64 Go

- gtx980beta : Nvidia GTX 980 avec 4Go, Nvidia GT 1030 avec 2Go

- gtx980tigamma : Nvidia GTX980Ti avec 6Go, Nvidia GTX 750 avec 2Go

- k40 : Nvidia K2000 avec 2Go, Nvidia Tesla K40 avec 12Go

- gt640 : Nvidia GT 640 avec 2Go, Nvidia RTX 2070 avec 8Go

- 4 stations de travail Precision T7810 avec 2 E5-2630v3 et 32 Go

- gtx780beta : Nvidia GTX 780 avec 3Go, Nvidia K420 avec 2Go

- gtx780gamma : Nvidia GTX 780 avec 3Go, Nvidia K420 avec 2Go

- gtx780delta : Nvidia GTX 780 avec 3Go, Nvidia GT1030 avec 2Go

- gtx1050ti : Nvidia GTX 1050Ti avec 4Go, Nvidia P600 avec 2Go

- 2 stations de travail Precision 7820 avec 2 Silver 4114 et 64 Go

- p600alpha : Nvidia P600 avec 2Go, Nvidia GTX 1080 avec 8Go

- p600beta : Nvidia P600 avec 2Go, Nvidia GTX 780 avec 8Go

- 2 postes de travail Optiplex 790 avec 1 i3-2120 et 16 Go

- o790alpha : Nvidia NVS 315 avec 1Go

- o790beta : Nvidia GT620 avec 1Go

- 4 postes de travail Optiplex 760 : 8Go

- o760alpha : Nvidia GT 620 avec 1Go, Intel Q6600

- o760beta : Nvidia GT 620 avec 1Go, Intel E7500

- o760gamma : Nvidia GT 430 avec 1Go, Intel E5200

- o760delta : Nvidia GT 620 avec 1Go, Intel E5400

Ces machines sont accessibles par SSH ou x2go : <nom>.cbp.ens-lyon.fr

Une vision d'ensemble de l'état des stations de travail sous SIDUS est accessible seulement de l'intérieur de l'ENS-Lyon.

L'utilisateur dispose sur ces machines de 6 espaces de stockage :

- son compte utilisateur

$HOME: monté en NFS, il ne doit pas être trop sollicité pour des calculs nécessitant de gros transferts. Un archivage (permettant de revenir sur l'état du volume dans le passé) est réalisé chaque nuit. - l'espace temporaire

/tmp: ce dossier est en mémoire vive. Rapide, il est raisonnable de ne pas trop le solliciter pour les gros volumes. Une fois la mémoire vive remplie, des dysfonctionnements peuvent apparaître. - l'espace local

/local: ce dossier correspond à un disque dur interne. La vitesse d'accès est d'une centaine de MB/s. Il n'est ni partagé, ni sauvegardé. Pour l'exploiter, créer un dossier correspondant à son identifiant :mkdir /local/$USER - l'espace vrac ancien

/scratch: ce dossier, partagé mais non sauvegardé entre toutes les machines, dispose d'un accès rapide sur le réseau de la salle et très rapide sur le réseau du cluster. Pour l'exploiter, créer un dossier correspondant à son identifiant :mkdir /scratch/$USER - l'espace vrac récent

/distonet: ce dossier, partagé mais non sauvegardé entre toutes les machines, dispose d'un accès rapide sur le réseau de la salle et très rapide sur le réseau du cluster. Pour l'exploiter, créer un dossier correspondant à son identifiant :mkdir /distonet/$USER - l'espace projets

/projects: ce dossier, archivé mais non sauvegardé entre toutes les machines, dispose d'un accès rapide sur le réseau de la salle et sur le réseau du cluster. Pour l'exploiter, créer un dossier correspondant à son identifiant :mkdir /projects/users/$USER

Machines ouvertes en salle 3IP à accélérateur AMD ou Nvidia

- 8 stations de travail ouvertes

- fx9590 : processeur AMD FX9590 cadencé à 4715MHz

- Nvidia Tesla C0160 avec 4GB

- Nvidia Quadro FX4800 avec 2GB

- kaveri : processeur AMD Kaveri A10-7850

- AMD GPU d'un A10-7850

- AMD Radeon HD7970

- AMD Radeon R9-290

- ryzen7 : processeur Ryzen7-1800X

- AMD Radeon R9-Fury

- AMD Radeon R9-380

- skylake : processeur Intel Skylake i7-6700K

- AMD Radeon R9-295×2

- AMD RX Vega 64

- threadripper : processeur ThreadRipper 1950X

- AMD Radeon VII

- AMD Radeon Vega 64

- AMD Radeon Nano

- i9900ks : processeur Intel i9-9900 KS

- Nvidia RTX 2080Ti avec 12 Go

- ryzen3800 : processeur Ryzen 3800X

- Nvidia RTX 2080Ti avec 12 Go

- phi7210 : processeur Xeon Phi 7210

- avec 64 coeurs et 256 threads

Ces machines sont accessibles en salle 3IP et par SSH et x2go : <nom>.cbp.ens-lyon.fr

Bureau M7-1H07 avec capacité 3D

- 1 station de travail Precision T7600 avec 2 Saondy Bridge 8 coeurs

- k4000 : Nvidia Quadro K4000 avec 2 Go avec 2Go

Équipements spécifiques

- un cluster 64 bits de 84 noeuds permanents et sa frontale

- accès par lethe.cbp.ens-lyon.fr avec soumission par GridEngine

- 24 stations d'intégration :

- lenny32 & lenny64 : distributions Debian Lenny 32/64 bits

- squeeze32 & squeeze64 : distributions Debian Squeeze 32/64 bits

- wheezy32 & wheezy64 : distributions Debian Wheezy 32/64 bits

- jessie32 & jessie64 : distributions Debian Jessie 32/64 bits

- stretch32 & stretch64 : distributions Debian Stretch 32/64 bits

- sid32 et sid64 : distributions Debian Sid 32/64 bits

- ubuntu32-1004 & ubuntu64-1004 : distributions Ubuntu 10.04 32/64 bits

- ubuntu32-1204 & ubuntu64-1204 : distributions Ubuntu 12.04 32/64 bits

- ubuntu32-1404 & ubuntu64-1404 : distributions Ubuntu 14.04 32/64 bits

- ubuntu32-1604 & ubuntu64-1604 : distributions Ubuntu 16.04 32/64 bits

- centos32-55 & centos64-55 : distributions CentOS 5.5 32/64 bits

- centos32-7 & centos64-7 : distributions CentOS 7 32/64 bits

Machines virtuelles à accélérateur

- 14 stations de travail virtuelles

- phi7120p : Xeon Phi 7120p avec 12GB

- k40m : Nvidia Tesla K40m avec 12GB

- k80alpha : 1/2 de Tesla K80 - 1GPU avec 12GB

- k80beta : 1/2 de Tesla K80 - 1GPU avec 12GB

- k80gamma : Tesla K80 - 2GPU avec 12GB

- gtx1080alpha : Nvidia GTX 1080 avec 8GB

- gtx1080beta : Nvidia GTX 1080 avec 8GB

- gtx1080gamma : Nvidia GTX 1080 avec 8GB

- gtx1080delta : Nvidia GTX 1080 avec 8GB

- p100alpha : Nvidia Tesla P100 avec 16GB

- p100beta : Nvidia Tesla P100 avec 16GB

- p100gamma : 2x Nvidia Tesla P100 avec 16GB

- v100alpha : Nvidia Tesla V100 avec 16GB

- v100beta : Nvidia Tesla V100 avec 16GB

Ces machines sont accessibles par SSH et x2go : <nom>.cbp.ens-lyon.fr

Stations Deep Learning à accélérateur

- 6 stations de travail “ouvertes”

- openstation6 : 1 RTX 2080 Super avec 8GB, 1 GTX 1080 avec 8GB, espace de stockage de 4TB en SSHD

- openstation7 : 1 RTX 2080 Super avec 8GB, 1 GTX 1080 avec 8GB, espace de stockage de 4TB en SSHD

- openstation8 : 1 RTX 2080 Super avec 8GB, 1 GTX 1080 avec 8GB, espace de stockage de 4TB en SSHD

- openstation9 : 1 RTX 2080 Super avec 8GB, 1 GTX 1080 avec 8GB, espace de stockage de 4TB en SSHD

- openstation5 : 1 Nvidia GTX 780 avec 3GB, espace de stockage de 4TB en SSHD

- openstation4 : 1 Nvidia GTX 780 avec 3GB, espace de stockage de 4TB

- 5 stations rackables

- r5400alpha : Nvidia GTX 1080 avec 8GB, espace de stockage de 1TB en Raid1

- r5400beta : Nvidia GTX 1080 avec 8GB, espace de stockage de 1TB en Raid1

- rome4gpu : 4 Nvidia RTX 2080 Super avec 8GB, expace de stockage de 3TB en Raid5

- epyc1 : Nvidia RTX 2080 avec 8GB, espace de stockage de 10TB en Raid5

- epyc2 : Nvidia RTX 2080 avec 8GB, espace de stockage de 10TB en Raid5

Ces machines sont accessibles par SSH et x2go : <nom>.cbp.ens-lyon.fr

Infrastructure SIDUS

L'infrastructure SIDUS pour Single Instance Distributing Universal System permet aux personnes de l'ENS qui le désirent de démarrer en quelques secondes un environnement scientifique complet, basé sur la dernière distribution stable de Debian, la Jessie à l'heure actuelle. Cet environnement peut aussi bien démarrer sur une machine complète ou dans une machine virtuelle. Il y a 5 options possibles pour lancer cette version :

- Debian Stretch on x86_64 : default pour l'usage dans un environnement 64 bits, optimisé pour un environnement virtuel sous VirtualBox ;

- Debian Stretch on x86_64 : OverlayFS version identique à la précédente, mais avec du OverlayFS à la place de AUFS

- Debian Stretch on x86_64 : Nvidia Current support propriétaire avec pilote & environnement le plus récent

- Debian Stretch on x86_64 : Nvidia Screenless support propriétaire avec pilote & environnement le plus récent, pour machines sans moniteur

- Debian Stretch on x86_64 : Nvidia 340xx support propriétaire avec pilote & environnement 340.*, pour cartes graphiques anciennes (GT200 inclues)

- Debian Stretch on x86_64 : Nvidia 304xx support propriétaire avec pilote & environnement 340.*, pour cartes graphiques très anciennes (GT200 inclues)

- Debian Stretch on x86_64 : AMD/ATI support propriétaire avec pilote & environnement, pour cartes graphiques AMD

Postes de travail

Les postes de travail, à la demande des utilisateurs, peuvent être configurés et pris en charge comme les autres équipements, seulement s'ils entrent dans le cadre d'un projet soutenu dans le CBP (pour ne pas interférer avec la DSI ou les informaticiens de entités concernées).